ChatGPTやGeminiといった対話型AIを使っていて「これ、本当かな?」と不安になったことはありませんか?

AIはとても便利ですが、時としてもっともらしい嘘をつくことがありますよね。

なぜ、わざとではないのに間違いが起きてしまうのでしょうか?

この記事では、AIが嘘をつく理由や、実際にあった失敗の具体例を徹底解説します。

AIの回答に騙されないための役立つ対策も一緒にご紹介するので、ぜひ参考にしてくださいね。

信頼度が実は低い?AI検索のリアルな現状

ChatGPTやGeminiといった対話型AIは、調べ物をする時、相談事がある時、アイデアを出して欲しい時などに使う方も多いですよね。

仕事や学習、オフでも便利な対話型AIですが、AIは時に嘘をつく=真実ではない情報を提供することがあります。

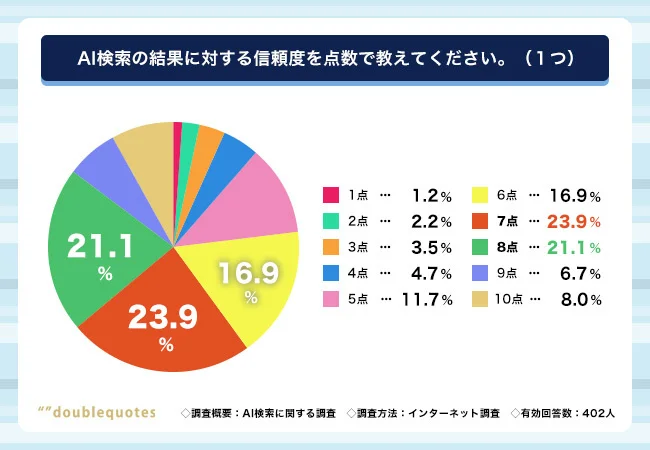

そこで、Z世代の20代男女402名に「AI検索の結果に対する信頼度を点数で教えてください(1~10点で回答)」という質問をしたところ、非常に興味深い事実が明らかになりました。

AIを使って調べものをするZ世代のうち、10点満点で「完全に信頼している」と答えた人は、わずか8%という結果に。

最も多かったのが7点(23.9%)で、6~8点に回答が集中しました。

つまり、AIのことを完全に信頼している人は非常に少なく、どこかでAIを疑いながら使っているようです。

このように、今の若い世代は「AIは便利だけれど、間違いや嘘もある」と冷静に判断していることが伝わってきます。

なぜAIは堂々と嘘をつくのか?「ハルシネーション」の仕組み

AIがまるで本当のことのように嘘をつく現象は、「ハルシネーション」と呼ばれています。

これは日本語で「幻覚」という意味ですが、AIが幻覚を見ているわけではありません。

AIが嘘をついてしまう最大の理由は、「AIが事実かどうかを確認してから話すという仕組みで作られていないから」です。

AIの主な役割は、人間が入力した言葉に対して「次に来る確率が最も高い言葉」を順番に選び、自然な文章を作ることです。

例えば、料理のレシピを聞かれたとき、AIはこれまでに読み込んだ膨大なデータの中から「パンの作り方について書くなら、次は小麦粉という言葉が来るのが自然だ」「その次は混ぜるという言葉が来るはずだ」と一文字ずつ予測して文章を組み立てていきます。

このとき、AIは「その内容が本当に正しいか」を検証しているのではなく、「文章として不自然ではないか」を一番に考えています。

そのため、自分が知らないことや学習データにないことを聞かれた場合でも、AIは「わかりません」と答える代わりに、手持ちの言葉を組み合わせて「もっともらしい文章」を新しく作り出してしまうのです。

これが、AIが堂々と嘘をついているように見える原因です。

AIにとっては、内容が事実であることよりも、人間にとって読みやすいスムーズな文章を完成させることが優先されてしまいます。

また、学習元となるインターネット上の情報の中に、古いデータや間違った内容が含まれていることも、AIが誤った回答を出してしまう大きな要因となっています。

調査データから判明した「AIが信頼を失う」3つの典型的なパターン

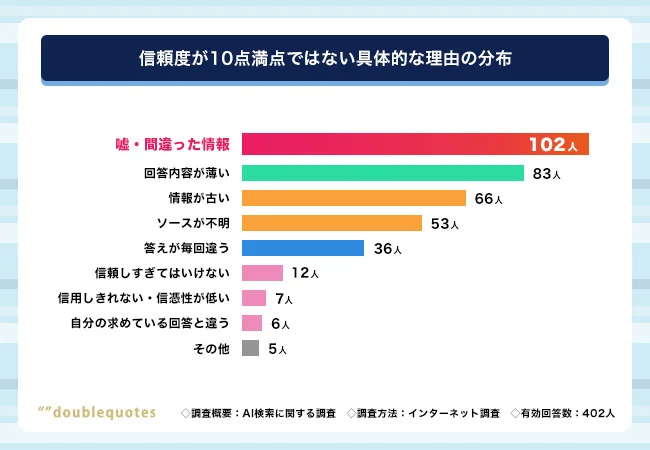

さらにAIの信頼度を調査するべく、10点満点で「完全に信頼している」と回答した方以外に向けて、「信頼度が10点満点ではない具体的な理由」を質問しました。

その結果「嘘・間違った情報」(102人)が最も多く、続いて、「回答内容が薄い」(83人)、「情報が古い」(66人)となっています。

この上位3つの回答が、AIが信頼を失う3つの典型的な失敗パターンであると考えられます。

パターン1:存在しないものを「ある」と言い張る

調査の中で最も多くの人が指摘したのが「嘘や間違った情報」です。

102人もの人がこの問題を挙げており、AIの信頼性を損なう最大の原因となっています。

具体的には、以下のような回答がありました。

『存在しない商品を存在するかのように回答された』

『ソースがわからない、本当に正しい情報なのか不安』

このように、AIは自分が知らないことでも、これまでのデータから予想して「もっともらしい嘘」を作り上げてしまいます。

利用者が実際にそのお店に行ってみたら影も形もなかったという経験が、AIへの不信感につながっています。

パターン2:中身が薄く、当たり障りのないことしか言わない

次に多かったのが、回答の「内容が薄い」という不満です。

83人の人がこの点に物足りなさを感じています。

質問に対して間違いではないものの、誰でも知っているような一般的なことしか言わなかったり、具体的なアドバイスが欠けていたりする場合です。

具体的には、以下のような回答がありました。

『内容に間違いはないが、当たり障りない文言で具体性にやや欠けるから』

『2回同じニュアンスで質問したが返答が違った時があり完璧ではないのだと感じました。』

利用者が本当に知りたい専門的な情報や、深い悩みに対する解決策を求めても、AIが表面的な言葉を並べるだけでは「これなら自分で調べたほうが早い」と思われてしまうのです。

パターン3:時間が止まっているかのような古い情報

3つ目は、情報の「鮮度」に関する問題です。

66人の人が、AIが古い情報をもとに回答していることを指摘しています。

今の流行や、つい最近決まったルールなどを聞いても、AIが学習した数年前のデータをもとに答えてしまうため、現実とのズレが生じます。

具体的には、以下のような回答がありました。

『少し前の情報をもとに回答されたからです。』

『ランチのおすすめを聞いたけれど、今は閉店していたり、営業時間が違ったり、そもそもない店もあったから』

特にランチのお店探しなどの日常的な場面では、昨日の営業時間が今日も同じとは限りません。

最新の情報を求めている利用者にとって、数年前のデータを得意げに話されてしまうと、AIへの信頼度も下がってしまいますよね。

AIの嘘に騙されないための3つの対策

AIに騙されないためには、ただ答えを受け取るのではなく、いくつかのポイントを確認する習慣を持つことが大切です。

ここでは、誰でもすぐに試せる3つ対策をお伝えします。

情報のソースがどこにあるか確認する

まず、AIの回答に含まれる情報の根拠がどこにあるのかを確認しましょう。

今回の調査でも「ソースが不明で不安」という声が多くありましたが、AIはもっともらしい嘘をつくのが得意です。

もし可能であれば、AIに対して「その情報の元になったサイトや資料を教えて」と聞いてみてください。

具体的な名前やURLが出てこない場合や、教えてもらったURLがリンク切れで見られない場合は、AIがその場で作り出した嘘である可能性が高いと考えたほうが安全です。

いつの時点の情報かを常に疑ってみる

AIが持っている知識には期限がある、ということを前提にしましょう。

例えば、最新のランチ情報や今現在のニュースについては、AIが知らないことも多いのです。

回答の中に「以前の情報では」といったニュアンスが含まれていないか、あるいは今の状況と矛盾していないかをチェックしてください。

特に、お店の営業時間や商品の価格などは変わりやすいため、AIの答えを鵜呑みにせず、最新の情報を扱っている公式サイトなどで日付を確認する癖をつけるのがおすすめです。

数字や名前は必ず別の方法で調べ直す

人の名前や電話番号、住所、あるいは計算結果などの「間違えてはいけない情報」については、必ず検索エンジンなどを使ってダブルチェックをしてください。

AIが出してくれた答えをキーワードにして、改めてGoogleなどで検索し直すことで、その情報が本当に正しいのかどうかを確かめることができます。

この「ひと手間」を加えるだけで、AIの嘘に振り回されるリスクをぐっと減らすことができます。

まとめ

AIはとても便利な道具ですが、100パーセント信頼できる完璧なものではありません。

Z世代を対象にした調査結果からもわかる通り、多くの人がAIの便利さを認めつつも、その間違いに対して冷静な視点を持っています。

AIがもっともらしい嘘をついてしまうのは、悪意があるからではなく、あくまで「自然な文章を作ること」を優先する仕組みだからです。

私たちはAIが出した答えをすべて鵜呑みにするのではなく、どこかに間違いが含まれているかもしれないという前提で向き合うことが大切です。

特に重要な判断が必要な場面では、Google検索やYahoo検索などの検索エンジンを使い、公式サイトや信頼できる資料を見て真偽を確かめるようにしましょう。

AIは正しく使いこなせば、私たちの生活や仕事を大きく支えてくれる心強いパートナーになります。

AIの得意なことと苦手なことをしっかりと理解して、便利に活用してみてください。